Audio Toolbox und Audio Toolbox Interface für die SpeechBrain- und Torchaudio-Bibliotheken ermöglichen komplexe Signalverarbeitungs- und -analyseaufgaben an Ton- und Sprachsignalen mit vortrainierten KI-Modellen.

Mithilfe einzelner Funktionsaufrufe und ohne jegliche Deep-Learning-Expertise können Sie Folgendes tun:

- Sprache mit automatischer Spracherkennung (ASR) mithilfe von STT-Pipelines (Sprache-zu-Text) transkribieren

- Sprache mithilfe von TTS-Pipelines (Text zu Sprache) synthetisieren

- Sprache mit der Stimmaktivitätserkennung (VAD) erkennen, gesprochene Sprachen ermitteln und Laute klassifizieren

- Sprecher per Deep-Learning-Modelle und Machine-Learning-Pipelines zur Sprechererkennung anmelden und identifizieren

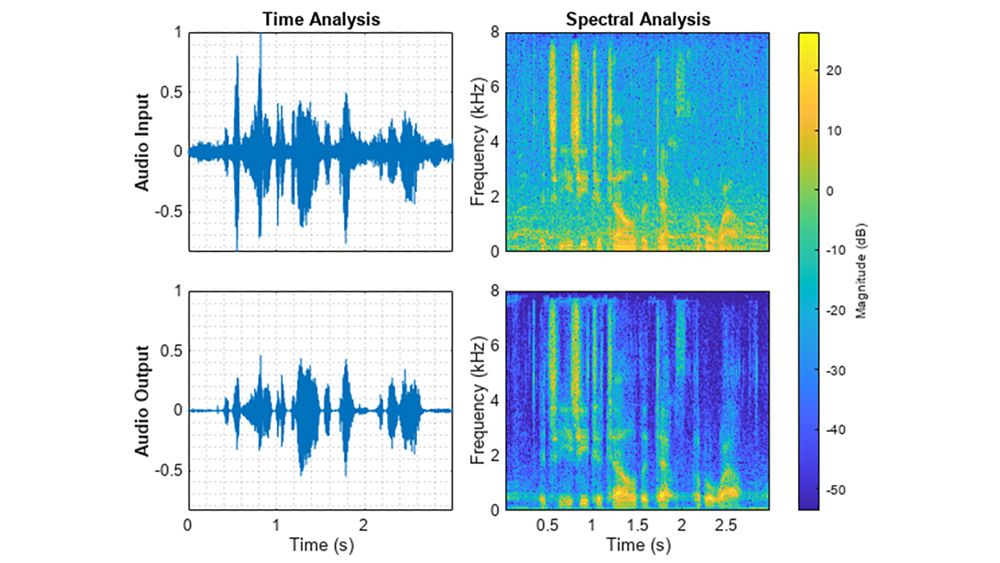

- Sprachquellen in einem Cocktailparty-Problem trennen sowie Sprachsignale verbessern und entrauschen

- Musikalische Tonhöhen schätzen und Einbettungen aus Ton-, Sprach- und Musiksignalen extrahieren

Die Funktionen verwenden vortrainierte Machine-Learning- und Deep-Learning-Modelle. Sie werden mithilfe einer Kombination aus MATLAB, Python® und PyTorch® ausgeführt.

Audio Toolbox Interface für die SpeechBrain- und Torchaudio-Bibliothek

Das Audio Toolbox Interface für die SpeechBrain- und Torchaudio-Bibliothek ermöglicht die Verwendung einer Sammlung vortrainierter KI-Modelle mit Audio-Toolbox-Funktionen zur Signalverarbeitung und -analyse.

Die Schnittstelle automatisiert die Installation von Python und PyTorch. Sie lädt ausgewählte Deep-Learning-Modelle aus der SpeechBrain- und Torchaudio-Bibliothek herunter. Nach der Installation führt sie folgende Funktionen durch die zugrunde liegende Verwendung lokaler KI-Modelle aus:

speech2textakzeptiert einspeechClient-Objekt, wenn das Modell aufemformeroderwhispergesetzt ist. Zudem steht das lokale Modellwav2veczur Verfügung, sowie die Cloud-Service-Optionen wie beispielsweiseGoogle,IBM,MicrosoftundAmazon. Bei der Verwendung vonwhispermüssen auch die Modellgewichte getrennt heruntergeladen werden, wie in Download Whisper Speech-to-Text Model (Sprache-zu-Text-Modell Whisper herunterladen) beschrieben.text2speechakzeptiert einspeechClient-Objekt, wenn das Modell aufhifigangesetzt ist. Zudem stehen die Cloud-Service-Optionen wie beispielsweiseGoogle,IBM,MicrosoftundAmazonzur Verfügung.

Die speech2text- bzw. text2speech-Funktion akzeptiert Textstrings und Audioauschnitte und gibt sie zurück. Diese Funktionen erfordern kein Programmieren der Signalvorverarbeitung, Merkmalsextraktion, Modellvorhersage und Ausgabenachverarbeitung,

Direkt einsatzbereite KI mit zusätzlichen Funktionen für Sprache und Ton

Die Audio Toolbox umfasst zusätzliche Funktionen wie classifySound, separateSpeakers, enhanceSpeech, detectspeechnn, pitchnn und identifyLanguage. Mit diesen Funktionen können Sie komplexe Deep-Learning-Modelle zur Verarbeitung und Analyse von Tonsignalen ohne jegliche KI-Expertise verwenden. Diese Modelle erfordern kein Audio Toolbox Interface für die SpeechBrain- und Torchaudio-Bibliothek.

Einsatz von MATLAB und PyTorch bei der Entwicklung von Deep-Learning-Modellen

MATLAB- und PyTorch-Benutzer, die mit Deep Learning vertraut sind, können beide Sprachen gemeinsam verwenden, um KI-Modelle zu entwickeln und zu trainieren, auch durch Co-Ausführung und Modellaustausch-Workflows.

Weitere Informationen: